Экономия расходов и удобство обслуживания: плюсы онлайн-кассы в аренду В современном бизнесе важно расходы

От медицинского оборудования до авиационной промышленности, прецизионная металлообработка с успехом

В мире дизайна интерьера существует бесконечное количество возможностей для творчества и самовыражения.

В поисках новых идей и вдохновения мы часто обращаемся к различным ресурсам в интернете. Однако, не всегда

Создание поделок из картона – это увлекательное и творческое занятие, которое подходит как для

Морские свинки и хомяки – очаровательные и популярные домашние питомцы, которые радуют своих владельцев

Брендирование автомобилей – это процесс создания узнаваемого визуального образа автомобиля, который

Радуга – это прекрасное и яркое явление природы, которое можно передать на бумаге. Если малышу

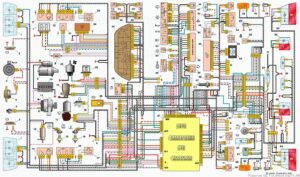

Электросхема ваз 2111 (8 и 16 клапанов): поиск поломок и замена электрооборудования Чтобы автомобиль

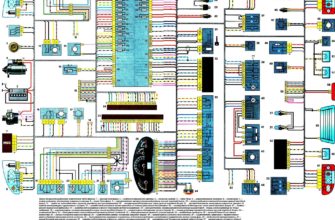

Электросхема автомобиля lada kalina: поиск поломок и замена электрооборудования Никакие работы по доработке